基于 YOLO 的人形机器人模块化目标检测系统

摘要

在机器人领域,计算机视觉仍是阻碍发展的重要瓶颈,许多任务因视觉系统效率低下而受限。本研究提出一种通用视觉模块,该模块利用最先进的 YOLOv9 框架,专门针对机器人等计算资源受限的环境进行优化。模型基于国际机器人运动联合会(FIRA)机器人人形机器人世界杯(Hurocup)的特定数据集进行训练。在机器人操作系统(ROS1)中,通过虚拟环境实现了新的视觉模块,确保其与 YOLO 的兼容性。采用每秒帧数(FPS)和平均精度均值(mAP)等指标评估系统性能,并在静态和动态场景下与现有的几何框架进行对比。结果表明,YOLO 模型虽然计算成本高于几何模型,但精度相当,且鲁棒性更优。

劳伦森智能移动机器人实验室

关键词:计算机视觉、机器学习、YOLO、机器人操作系统(ROS)

1 引言

在计算机视觉领域,基于人工智能的框架显著提升了检测速度和精度。卷积神经网络(CNNs)等人工智能目标检测技术的出现,使得传统目标检测策略逐渐被淘汰。然而,由于卷积神经网络在资源受限系统上计算成本较高,其在机器人领域的应用仍受到限制。机器学习框架通常需要大规模数据集和高性能图形处理器(GPU)才能达到良好性能,而机器人环境往往内存有限,甚至可能没有图形处理器。近年来,卷积神经网络框架性能取得了大幅提升,特别是最新的 YOLO(You Only Look Once)模型 YOLOv9,在多数方面的性能几乎超越了其他所有框架(Wang 等人,2024)。

本文设计并优化了一种基于 YOLOv9 的轻量级通用视觉模块,专门适用于人形机器人。为评估该模块的实用性,我们以国际机器人运动联合会(FIRA)人形机器人世界杯(Hurocup)为应用场景展开研究。该赛事要求机器人完成射箭、举重和篮球等对视觉要求较高的任务。该视觉模块设计为仅在中央处理器(CPU)平台上运行,以适应人形机器人常见的硬件限制。

本研究的目标主要有三个:(1)评估基于 YOLO 的检测系统在人形机器人典型硬件约束下的高效运行能力;(2)将其性能与传统视觉技术进行对比;(3)探讨目标检测框架集成到机器人系统中的广泛意义。通过验证 YOLO-based 检测在受限系统上的实时可行性,本研究有助于缩小尖端计算机视觉研究与机器人实际应用之间的差距。

2 文献综述

2.1 目标检测

计算机视觉涵盖多个子领域,目标检测作为关键领域,在自动驾驶(Arnold 等人,2019)、农业(Wang 等人,2020;Salazar-Gomez 等人,2021;Khan 和 AlSuwaidan,2022)、监控(Murugan 等人,2018;Angadi 和 Nandyal,2020)和医疗健康(Ahmed 等人,2025;Wang 等人,2022a)等实时应用中重要性日益凸显。现代目标检测需要同时完成目标分类和边界框定位任务,这对需要快速、准确决策的系统至关重要。

早期目标检测方法依赖于方向梯度直方图(HOG)等基于特征的技术,该技术在行人检测(Suard 等人,2006)和人脸识别(Déniz 等人,2011)中表现出较高精度。尺度不变特征变换(SIFT)通过关键点检测改进了匹配效果(Kasiselvanathan 等人,2020;Meng 等人,2013),而加速稳健特征(SURF)则提升了实时任务的性能(Li 等人,2012;He 等人,2019)。

深度学习和卷积神经网络的兴起彻底改变了目标检测领域。两阶段检测器(如 Fast R-CNN)注重精度,在路面裂缝检测(Xu 等人,2022)和面部表情识别(Li 等人,2017)中取得了成功。单阶段检测器(包括 SSD 和 YOLO 系列)则优先考虑速度,非常适合实时应用场景。

尽管基于人工智能的视觉技术已广泛应用于手术机器人(Ai 等人,2023)和基础设施监测(Ward 等人,2021)等领域,但在人形机器人领域的应用仍相对滞后。该领域的大多数研究侧重于交互和学习(Kanda 等人,2002;Oztop 等人,2004;Bao 等人,2023;Hester 等人,2010),而非目标检测。本文旨在利用实时目标检测的最新进展,开发一种适用于人形机器人平台的稳健视觉模块,以填补这一研究空白。

2.2 YOLO:实时目标检测框架

YOLO 框架是研究和工业领域广泛应用的领先单阶段目标检测器(Chen 等人,2023;Hussain,2023)。作为一种卷积神经网络模型,YOLO 通过卷积层、池化层和全连接层处理图像,实现目标检测和定位,并输出带标签的边界框和置信度分数。

2015 年推出的 YOLOv1 开创了单阶段检测方法的先河,实现了 45 帧 / 秒的检测速度和 63.4% 的平均精度(AP)(Redmon 等人,2016)。后续的 YOLOv2 进行了重大改进,平均精度达到 78.6%,速度为 40 帧 / 秒(Redmon 和 Farhadi,2016),2018 年推出的 YOLOv3 进一步优化了模型性能(Redmon 和 Farhadi,2018)。

2020 年的 YOLOv4 引入了马赛克增强和丢弃块正则化等关键技术(Bochkovskiy 等人,2020)。包括 YOLOv5 和 YOLOv6 在内的后续版本进一步提升了性能,其中 YOLOv6 的平均精度达到 35.9%,速度高达 1234 帧 / 秒(Li 等人,2022)。YOLOv7 则在速度和精度上均有提升(Wang 等人,2022b)。

最新版本 YOLOv9 引入了可编程梯度信息和 GELAN 架构,将该框架的性能提升到了新高度。尽管 YOLOv9 已在多个领域得到广泛应用,但尚未在人形机器人上实现部署。

2.3 机器人应用与视觉模块

视觉模块是机器人系统的关键组成部分,作为感官输入和决策之间的接口,其主要功能是解析视觉数据,以支持导航和目标检测等任务。早期系统依赖于分割、边缘检测和模板匹配等传统技术,这些方法在某些情况下虽有效,但在真实世界的变异性和噪声环境中表现不佳。人工智能的最新进展极大地提高了视觉模块的适应性和准确性,因此该领域的研究对现代机器人技术至关重要。

颜色分割和模板匹配等经典方法曾是机器人视觉的标准技术(Al-Jarrah 等人,2018;Hurtado 和 Valada,2022)。这些方法速度快且所需处理能力低,但鲁棒性不足。光照变化、背景杂乱和目标相似性等因素容易导致系统检测失败,影响性能。例如,颜色相似的物体或反光表面可能引发检测错误。

深度学习的出现彻底改变了机器人视觉领域。基于卷积神经网络的框架(如 YOLO、Faster R-CNN 和 SSD(单阶段检测器))能够在复杂场景中实现更精确的检测(Redmon 等人,2016;Liu 等人,2016;Ren 等人,2016)。这些模型通过大规模数据集训练,泛化能力远优于传统方法。然而,将其应用于机器人系统也带来了新的挑战。大多数机器人缺乏图形处理器,使得中央处理器实时推理难以实现。此外,构建大型多样化的训练数据集既耗时又耗费资源,光照变化、遮挡和杂乱等因素仍然是亟待解决的问题(Kasiselvanathan 等人,2020)。因此,为人形机器人设计视觉模块需要仔细平衡精度、速度和硬件约束。

2.4 研究空白

本研究旨在填补计算机视觉、基于 YOLO 的框架和机器人视觉交叉领域的关键空白。尽管 YOLO 已广泛应用于自动驾驶和监控等任务,但其在人形机器人中的应用仍非常有限。目前的视觉模块实现主要依赖于特定任务配置和传统技术,这使得它们在需要通用方法的任务中,或在国际机器人运动联合会(FIRA)比赛等不可预测的环境中难以发挥作用。本文利用 YOLO 开发了一种通用视觉模块,该模块平衡了效率和精度,可部署在资源受限的人形机器人上。通过解决计算约束和人形机器人缺乏通用视觉解决方案的双重挑战,本研究将为该领域做出贡献。借助各种优化工具并充分利用性能改进,YOLO 框架有望最终应用于人形机器人领域。

3 研究方法

3.1 硬件配置

本研究使用的人形机器人是 ROBOTIS-OP3(见图 1),该机器人高 51 厘米,重 3.5 千克,配备 20 个 XM430-W350-R 执行器和一个罗技 C920 高清专业网络摄像头。机器人由 11.1 伏 1800 毫安时锂聚合物电池供电或通过直接电缆连接供电。经过轻微改装,安装了 3D 打印的塑料手和脚。OP3 运行机器人操作系统(ROS1)Kinetic 版本,能够实现与硬件的顺畅交互,其计算效率和实时处理能力使其适合目标检测任务。本地图像处理减少了延迟,同时其模块化架构允许在需要时轻松过渡到外部计算。可通过虚拟网络计算(VNC)客户端或以太网电缆进行连接。

图 1:劳伦森智能移动机器人实验室(LIMRL)的两台人形机器人。左侧所示的 ROBOTIS-OP3(又名奥斯卡)将用于本研究的系统实现,视觉模块也将安装在右侧所示的北极星(Polaris)机器人上。

3.2 YOLOv9 的准备与训练

如前所述,本项目将 YOLO 目标检测框架集成到人形机器人中,以实现在硬件约束下的实时检测,并确保视觉系统和控制系统之间的快速通信。该软件栈结合了预训练模型、开源库和中间件,以保持灵活性和可重复性。该系统基于机器人操作系统(ROS)实现,利用其模块化设计和丰富的库支持。机器人操作系统(ROS)支持摄像头、YOLO 推理和执行器控制的无缝集成。开发语言采用 Python,并利用 PyTorch 和 OpenCV,这两个工具对于基于 YOLO 的计算机视觉任务至关重要。

选择 YOLO 是因为其在速度和精度之间取得了良好的平衡。最新版本 YOLOv9 引入了可编程梯度信息(PGI)和 GELAN 架构,提升了推理速度和精度,非常适合机器人部署。本文将 YOLO 应用于国际机器人运动联合会(FIRA)人形机器人世界杯(Hurocup)的三个项目:射箭、马拉松和篮球。表 1 展示了训练中使用的目标示例。在射箭项目中,模型检测移动目标并向其中心发射箭矢。在马拉松项目中,机器人跟随一条红线,并对方向箭头标记(左、右、前)进行分类,这些箭头可能会出现旋转情况。在篮球项目中,机器人检测橙色球,将其拾起,找到红色球网,靠近球网并在足够近的距离时投篮。

表 1:按项目分类的数据集目标示例表

| YOLOv9 训练目标示例 | ||

|---|---|---|

| 模型名称 | 描述 | 图像 |

| 篮球 | ||

| 球 | 儿童尺寸使用乒乓球,成人尺寸使用更大的网球。 | |

| 篮筐 | 机器人需要投篮得分的亮色篮球筐。儿童尺寸篮筐直径为 10 厘米,成人尺寸篮筐直径为 30 厘米。 | [无标题图像] |

| 射箭 | ||

| 目标 | 直径为 50 厘米的射箭靶。 | |

| 马拉松 | ||

| 线 | 机器人需要跟随的红色引导线。 | [无标题图像] |

| 右箭头 | 箭头指向右侧的标记。 | |

| 左箭头 | 箭头指向左侧的标记。 | |

| 前箭头 | 箭头指向正前方的标记。 |

训练过程始于收集和预处理特定任务的数据集。为了平衡性能和效率,我们针对每个任务训练多个较小的模型,而不是一个大型模型。每个数据集对应国际机器人运动联合会(FIRA)人形机器人世界杯(Hurocup)的特定项目,例如篮球项目的球和球网,或马拉松项目的箭头标记(见表 3.1)。使用 Roboflow 的 YOLOv9 格式,通过边界框对数据集进行标注,标签包括类别 ID 和标准化边界框坐标。Roboflow 还处理旋转、光照变化和缩放等数据增强任务,以提高模型的泛化能力(Pellegrino 等人,2024;P 等人,2023;Gupta 等人,2023)。

训练在配备英伟达(Nvidia)RTX 1650 图形处理器的设备上,使用 PyTorch 进行。模型训练 100 个周期,批次大小为 6,紧密马赛克阈值为 50。为避免过拟合,设置耐心值为 5,即如果五个周期内没有性能提升,则停止训练,该值是通过先前的实验确定的最优值。图像以 640×640 分辨率进行处理,训练基于预训练的 MSCOCO 权重开始(Ultralytics,2024)。采用了三种架构:YOLOv9-Tiny、YOLOv9-Small 和 YOLOv9-Medium,这些都是最轻量级的变体。训练通过外部笔记本电脑的命令行执行,以减少机器人自身的计算负载。

3.3 机器人操作系统(ROS)集成

该视觉模块与机器人操作系统(ROS)紧密集成,确保摄像头、推理流水线和 OP3 执行器之间的无缝通信。该架构由三个核心组件组成:YOLO 节点、监听节点和特定项目节点。

机器人操作系统(ROS)采用发布 / 订阅通信模型,允许节点通过命名主题异步交换数据。这种模块化方法提高了系统的灵活性,节点可以独立运行,同时高效地交换数据。在该系统中,YOLO 节点将检测结果发布到一个主题,监听节点订阅该主题,对数据进行格式化处理,并将其路由到相应的项目模块。

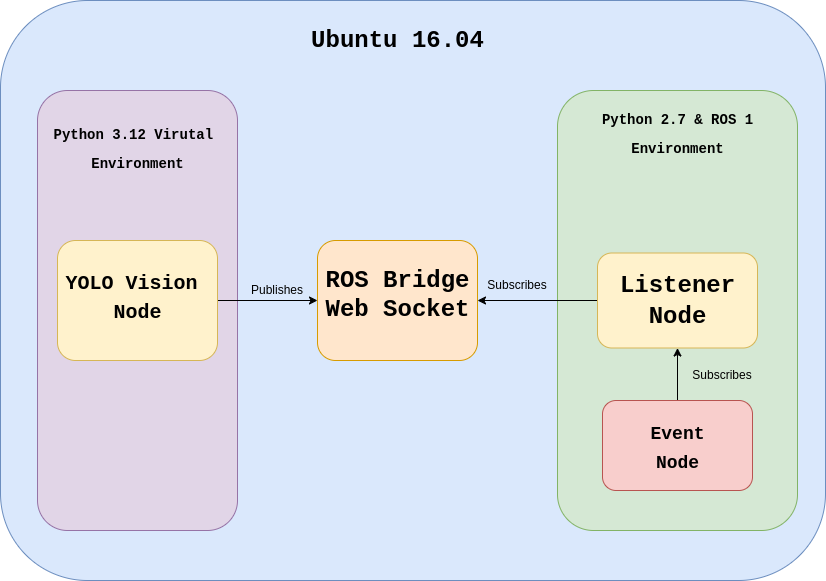

由于兼容性问题(机器人操作系统(ROS)依赖 Python 2.7 和 OpenCV 3.3.1,而 YOLO 需要 Python 3),YOLO 节点在配备 OpenCV 4.11 的 Python 3.12 虚拟环境中运行。这种隔离设计使其能够利用 PyTorch 等优化库进行模型推理。该节点订阅摄像头视频流,将视频帧调整为模型的输入尺寸并进行处理,然后执行目标检测。检测结果(边界框、标签和置信度分数)通过 WebSocket 以 JSON 格式发布。监听节点接收这些数据,并将其重新发布到适合每个项目的机器人操作系统(ROS)主题上。为了优化性能,可以将推理频率限制为每秒 20 次检测,而不是处理每帧图像。图 2 直观展示了所使用的各种环境。

图 2:视觉模型各种环境中机器人操作系统(ROS)节点之间的交互流程图。机器人操作系统(ROS)桥接 WebSocket 对于确保两个环境之间的正常通信至关重要。

YOLO 与 Python 2.7 之间的上述兼容性问题,需要一个独立的监听节点通过 WebSocket 接收检测数据,并将其重新发布到 /yolo/bboxes 主题。该节点使特定项目模块能够以机器人操作系统(ROS)兼容的格式访问检测结果,而无需与 YOLO 节点直接集成。每个项目节点订阅 /yolo/detections 主题,并利用这些数据识别目标,启动接近或躲避等动作。目标跟踪通过预先编写的 Python 逻辑处理,执行器控制通过 Dynamixel SDK 管理。

考虑到 OP3 有限的中央处理器(CPU)性能,实时推理性能仍然是一个挑战。为缓解这一问题,训练在外部设备上进行,同时通过跳帧和将输入尺寸调整为 640×640 分辨率,优化机器人自身的推理过程。由于 OP3 缺乏图形处理器(GPU),YOLO 模型被转换为 OpenVINO 格式以提高中央处理器(CPU)的运行效率。这一过程首先将模型转换为 ONNX 格式,通过量化减少计算负载。机器人操作系统(ROS)的模块化特性进一步允许轻松替换或扩展其他检测模型。

3.4 性能评估

为确保系统性能可靠,新的视觉模块将在静态和动态环境中进行全面测试。初步评估将在受控的实验室环境中进行,减少背景干扰并保持光照稳定。机器人将处于静止状态,评估其目标检测能力,以测量可重复环境中的帧速率和延迟。

静态测试之后,将在真实环境中评估视觉模块,让机器人完成国际机器人运动联合会(FIRA)人形机器人世界杯(Hurocup)的三个项目:射箭、篮球和马拉松。采用每秒帧数(FPS)、精度、召回率、平均精度均值 50(mAP50)和平均精度均值 50-95(mAP50-95)等量化指标评估性能。静态和动态每秒帧数(FPS)测量将有助于评估延迟和一致性。通过将视觉模块的输出与几何方法和真实测量结果进行比较,测试距离估计的准确性。这种比较将突出系统的精度及其相对于先前方法的优势。扩展测试将确保系统的稳健性,并为动态条件下检测精度的迭代改进提供指导。

4 系统实现

4.1 模型部署

YOLO 模型的部署涉及漫长的训练过程,从数据集准备开始,最终实现实时推理。为了平衡速度和精度,每个类别的数据集不超过 150 张图像。使用 RoboFlow 对数据集进行手动标注,帮助模型聚焦于篮球或箭头标记等关键目标。采用旋转、剪切、曝光调整和高斯模糊等数据增强技术,提高系统的整体稳健性。

为实现实时推理,通过 ROBOTIS-OP3 的网络摄像头捕获视频流。使用 letterbox 调整大小功能处理每个捕获的帧,在保持图像纵横比的同时,将其调整为所需的输入尺寸(640 像素 ×640 像素)。采用多种技术优化模型,以适应基于中央处理器(CPU)的推理,包括将模型转换为 OpenVINO 格式。只有当边界框的置信度超过阈值时才会绘制,并应用非极大值抑制(NMS)过滤重叠的边界框,仅保留最准确的检测结果。然后将边界框缩放回原始图像尺寸,校正网络摄像头的纵横比,避免边界框失真。这一步骤对于确保在视频流中准确显示检测结果至关重要。使用 OpenCV 4.11 在检测到的目标上绘制边界框和类别标签,并显示置信度分数。

4.2 机器人操作系统(ROS)节点开发

由于 Python 版本不兼容,YOLO 目标检测系统通过两个独立的机器人操作系统(ROS)节点实现。机器人操作系统(ROS)Kinetic 版本需要 Python 2.7,而 YOLOv9 及其依赖项(如 PyTorch)需要 Python 3.8 或更高版本。为解决这一问题,检测节点在 Python 3.12 虚拟环境中运行,与机器人操作系统(ROS)隔离。第二个节点(监听节点)在 Python 2.7 环境中运行,通过机器人操作系统(ROS)桥接器,利用 WebSocket 接收检测结果。该桥接器实现了两个环境之间的无缝通信。

检测节点使用 PyTorch 和 Ultralytics 的 YOLOv9 进行推理,通过 WebSocket 将边界框数据作为 JSON 消息发送。每个 JSON 消息包含目标类别、坐标、尺寸和置信度分数。使用 OpenCV 4.11 在视频流上叠加检测结果,以便进行调试。该节点还包括清理程序,在关闭时释放摄像头资源并关闭 WebSocket 连接。

监听节点接收 JSON 数据,并将其重新发布为机器人操作系统(ROS)兼容的消息。该节点在机器人操作系统(ROS)环境中运行,确保所有其他特定项目节点能够订阅检测输出,而无需直接与 YOLO 交互。该节点将传入的数据记录到 rospy 中以便调试,并包含对格式错误消息或连接失败的错误处理功能。管理 WebSocket 生命周期事件,支持重新连接和诊断日志记录。

这种双节点架构确保可以使用现代深度学习工具,而不会影响机器人操作系统(ROS)的兼容性。模块化设计提高了可维护性和可扩展性,允许在不改变核心机器人操作系统(ROS)控制结构的情况下,对检测流水线进行未来升级。

4.3 流水线与行为集成

新的视觉模块通过基于机器人操作系统(ROS)架构的结构化流水线,集成到机器人框架中。该设置支持视觉系统和行为模块之间的高效数据交换,特别是在国际机器人运动联合会(FIRA)项目中,允许实时目标检测驱动机器人动作。

主要的实现挑战源于 YOLO 对 Python 3 的要求与机器人操作系统(ROS)Kinetic 版本对 Python 2.7 的依赖之间的冲突。为解决这一问题,创建了一个 WebSocket 桥接器,连接运行 YOLO 节点的 Python 3.12 虚拟环境和机器人操作系统(ROS)系统。初始设置中出现的问题(如虚拟环境默认使用 OpenCV 3.3.1 和 PIP 等 Python 2.7 库),通过使用 –no-site-packages 标志重构环境得以解决。这使得隔离的视觉节点能够与机器人操作系统(ROS)系统通信,而不会产生依赖冲突。

YOLO 视觉节点通过 WebSocket 将检测数据作为 JSON 消息发送。这些消息由监听节点接收,监听节点将数据重新打包为机器人操作系统(ROS)兼容的消息。这种解耦的异步通信确保了低延迟性能,这对于国际机器人运动联合会(FIRA)项目所需的快速反应至关重要。

现在,特定项目节点可以轻松订阅更新后的检测主题。启动一个项目只需更新 roslaunch 文件,使其指向新的视觉节点。激活后,这些节点解析边界框数据,确定目标位置,并根据目标的位置和距离,触发跟踪、转向或躲避等行为。

图 3:项目脚本所使用的流水线图。该图展示的是篮球项目的流水线。

机器人操作系统(ROS)的发布 / 订阅模型确保每个组件仅处理所需的数据,提高了效率和可扩展性。这种模块化结构在保持机器人操作系统(ROS)核心稳定性的同时,支持系统的可扩展性,非常适合未来的升级。感知与决策的分离提高了系统的可维护性,并确保系统能够支持国际机器人运动联合会(FIRA)比赛之外的其他任务。图 3 展示了项目进行过程中完整流水线的示例。

4.4 优化措施

优化 YOLOv9 模型对于在 ROBOTIS-OP3 的纯中央处理器(CPU)系统上实现实时性能至关重要。采用了跳帧、输入调整大小、模型转换和量化等多种策略,以减少推理延迟,同时保持检测精度。

最有效的方法之一是跳帧技术。系统不处理每个传入帧,而是处理每第 n 帧(n 是可配置参数)。这显著降低了计算负载,同时保持了系统的响应能力,使机器人能够跟踪目标并做出反应,而不会使中央处理器(CPU)过载。另一项关键优化是输入调整大小。在推理之前,将摄像头帧缩小到 YOLO 的原生输入尺寸 640×640 像素。这确保了高效处理,避免了不必要的高分辨率计算,加快了预处理和推理速度,同时保持了检测的可靠性。为进一步减少推理时间,将 YOLOv9 模型从 PyTorch 转换为开放神经网络交换(ONNX)格式,然后再转换为英特尔针对中央处理器(CPU)性能优化的工具包 OpenVINO。开放神经网络交换(ONNX)转换确保了模型的可移植性,而 OpenVINO 通过利用中央处理器(CPU)特定指令和修剪冗余操作,加速了推理过程。最后,应用量化技术减少模型大小和推理时间。使用 PyTorch 的量化工具将权重和激活值从 32 位浮点数降低到 8 位整数。这一步骤大大减少了内存使用,并加快了作为推理核心瓶颈的矩阵运算。

这些优化措施共同使 YOLOv9 系统能够在 OP3 的硬件限制内高效运行。通过结合模型级和硬件特定技术,该系统在速度和精度之间取得了良好的平衡,能够在要求苛刻的机器人环境中实现实时目标检测。

5 实验结果

5.1 YOLO 训练结果

训练 YOLOv9 模型是确保高检测精度并保持实时性能的关键步骤。在本研究的系统实现中,针对每个国际机器人运动联合会(FIRA)项目,使用 YOLOv9-Tiny(T)、Small(S)和 Medium(M)三种架构,共训练了九个模型。这种多模型策略有助于在精度和速度之间取得平衡,这对于部署在计算资源有限的 ROBOTIS-OP3 机器人上至关重要。为提高模型精度,所有模型都使用了在 MSCOCO 数据集上预训练的权重,这些权重可在 Ultralytics(2024)获取。此外,所有模型的训练耐心值均设置为 5,以避免过拟合。训练结果如表 2 所示。

表 2:YOLO 模型训练结果。所有模型均训练 100 个周期,耐心值设置为 5。

| YOLOv9 训练结果 | ||||

|---|---|---|---|---|

| 模型名称 | 平均精度均值 @0.5 | 平均精度均值 @0.5-0.95 | 精度 | 召回率 |

| 篮球 | ||||

| YOLOv9-T | 0.994 | 0.92536 | 0.98565 | 0.98383 |

| YOLOv9-S | 0.995 | 0.96225 | 0.98253 | 0.99809 |

| YOLOv9-M | 0.99472 | 0.95518 | 0.9859 | 0.98571 |

| 射箭 | ||||

| YOLOv9-T | 0.95946 | 0.92109 | 0.95934 | 1 |

| YOLOv9-S | 0.98321 | 0.91407 | 0.95782 | 1 |

| YOLOv9-M | 0.99393 | 0.82793 | 0.95612 | 1 |

| 马拉松 | ||||

| YOLOv9-T | 0.75063 | 0.68905 | 0.67078 | 0.89904 |

| YOLOv9-S | 0.78545 | 0.71538 | 0.61382 | 1 |

| YOLOv9-M | 0.73501 | 0.61436 | 0.5923 | 0.87498 |

不同项目的训练结果存在差异。在篮球项目中,三个模型在平均精度均值(mAP)、精度和召回率等指标上均取得了高分,表明模型具有较强的泛化能力,能够在不同帧中实现可靠检测。

相比之下,射箭项目的模型结果参差不齐。尽管召回率和平均精度均值 0.5(mAP0.5)较高,但平均精度均值 0.5-0.95(mAP0.5-0.95)的分数差异显著。结合较高的召回率分数,这表明模型存在过拟合现象:模型能够成功识别训练过程中见过的目标,但难以泛化到新数据。可能需要进一步研究或数据集增强,以提高其稳健性。

马拉松项目的模型整体表现最差,三种架构的平均精度均值(mAP)和精度均较低。尽管召回率相对较高,但模型的分类准确性有待提高。这主要是由于该项目中使用的视觉标记外观相似,特别是左右箭头,模型经常将它们混淆。图 4 中的混淆矩阵分析证实了这一常见错误模式。

图 4:YOLOv9-T 马拉松模型的混淆矩阵。该矩阵表明,由于左右箭头外观相似,模型经常将它们混淆。

模型性能的主要限制因素是数据集的泛化能力。考虑到 OP3 有限的计算资源,为实现实时推理,训练数据集必须保持较小规模。这一限制常常导致过拟合,模型记住训练样本,而不是学习稳健的特征表示。尽管这种权衡限制了马拉松等复杂项目的准确性,但对于保持实时操作性是必要的。

考虑到帧速率和效率方面的优越性能,最终选择了 Tiny(YOLOv9-T)模型进行部署。这些模型在速度和可接受的精度之间取得了最佳平衡,非常适合机器人视觉系统的实时要求。在所有优化措施均已应用且无目标的情况下进行的基准测试证实,Tiny 模型在空闲状态下持续提供最高的帧速率(见表 3)。因此,将使用 YOLOv9-T 模型对 YOLO 视觉模块进行性能测试。未来的研究可能会侧重于利用迁移学习或轻量级增强策略,在不牺牲速度的情况下提高模型的泛化能力。

表 3:空闲状态下的帧速率测试结果。在一分钟内没有检测到目标的情况下取平均值,以获得清晰的基准。

| 空闲帧速率测试结果 | |||

|---|---|---|---|

| 架构 | 篮球 | 射箭 | 马拉松 |

| YOLOv9-T | 7.99 帧 / 秒 | 8.01 帧 / 秒 | 7.98 帧 / 秒 |

| YOLOv9-S | 2.75 帧 / 秒 | 2.75 帧 / 秒 | 2.74 帧 / 秒 |

| YOLOv9-M | 0.86 帧 / 秒 | 0.86 帧 / 秒 | 0.84 帧 / 秒 |

5.2 实验设置与流程

为评估 YOLOv9 模块在机器人环境中的性能,进行了两种不同类型的实验:静态测试和动态测试。这些测试旨在测量系统在受控环境和实际应用场景中的推理速度、实时性能和准确性。此外,两种测试都将与目前在机器人上实现的几何方法进行比较,以此作为评估基于视觉的模型有效性的基准。所有测试都将在劳伦森智能移动机器人实验室(LIMRL)内进行,如图 5 所示。

图 5:所有实验(包括静态和动态实验)都将在劳伦森智能移动机器人实验室(LIMRL)的人造草皮场上进行,该场地与国际机器人运动联合会(FIRA)比赛中使用的场地类似。这张照片展示了篮球项目的实验设置。

静态测试通过在机器人保持静止状态下处理帧,分离视觉系统的性能。关键指标包括推理时间和每秒帧数(FPS),为实时可行性和计算负载提供基准。动态测试在操作条件下评估系统性能,机器人利用其视觉模块与环境交互。这揭示了运动、光照和实时需求对检测和响应能力的影响。

两种测试都与使用颜色分割和基于规则逻辑的几何基准进行比较。这种比较量化了速度、准确性和实用性之间的权衡,有助于评估基于 YOLO 的系统在机器人应用中的优势。

5.3 静态实验

在静态实验中(见表 4),YOLOv9 模型能够实现与现有几何模型相当的精度水平。在马拉松项目中,YOLO 模型的精度超过了几何模型。尽管 YOLO 模型的检测更具一致性,但它经常混淆箭头标记类型,导致假阳性检测。因此,YOLO 模块实现的真阳性检测数量可能比数据显示的更接近几何模型。

在每秒帧数(FPS)方面,几何方法的性能仍然更优,有时速度比 YOLO 模块快 50%。尽管进行了优化,YOLO 模块的运行速度仍然比几何模块慢得多,但 YOLO 模块具有几个关键优势。与当前基于颜色分割的方法不同,YOLO 等框架在训练后不需要任何校准,而基于颜色分割的方法需要漫长的微调周期才能获得良好的结果。其次,通过数据增强,YOLO 模块对环境变化的抵抗力更强。数据集增强(如亮度或旋转调整)使 YOLO 能够实现几何方法无法比拟的稳健性。如图 6 所示,几何方法经常受到背景噪声的干扰,而 YOLO 节点则可以完全忽略这些噪声。

表 4:新视觉模块的静态测试结果。每秒帧数(FPS)衡量速度,精度表示正确检测的百分比。

| 静态实验结果 | ||

|---|---|---|

| 模块 | 速度(帧 / 秒) | 精度 |

| 篮球 | ||

| YOLO 模块 | 5.92 | 91.6% |

| 几何模块 | 12.99 | 91.7% |

| 射箭 | ||

| YOLO 模块 | 6.22 | 92.24% |

| 几何模块 | 10.64 | 96.6% |

| 马拉松 | ||

| YOLO 模块 | 6.12 | 91.67%* |

| 几何模块 | 8.21 | 50.8% |

图 6:该图展示了在静态实验中,几何节点受到背景噪声干扰的示例。由于光照条件变化,该节点将背景物体检测为球的一部分,导致错误。YOLO 节点对这类噪声的抵抗力要强得多。

5.4 动态实验

在性能方面,动态实验的结果与静态实验相似(见表 5)。两个模块的每秒帧数(FPS)都有所降低,但它们之间的差距保持相似。唯一的例外是马拉松项目,在该项目中,由于几何模块需要处理更复杂的箭头标记检测任务,YOLO 模块的性能能够与几何模块相媲美。

表 5:新视觉模块的动态测试结果。每秒帧数(FPS)衡量速度,精度表示正确检测的百分比。

| 动态实验结果 | ||

|---|---|---|

| 模块 | 速度(帧 / 秒) | 精度 |

| 篮球 | ||

| YOLO 模块 | 6.68 | 83.71% |

| 几何模块 | 12.30 | 50.9% |

| 射箭 | ||

| YOLO 模块 | 4.41 | 90.1% |

| 几何模块 | 9.24 | 93.25% |

| 马拉松 | ||

| YOLO 模块 | 5.90 | 39.77% |

| 几何模块 | 8.49 | 55.5% |

不同项目的精度差异很大,这取决于它们的具体要求。在篮球项目中,YOLO 模块的性能优于几何模块。之前篮球项目的几何模块使用轮廓检测,由于光照条件变化,难以检测球形物体。尽管球检测设置为两种不同的分割模式并结合使用以适应光照变化,但这种方法仍然较为繁琐。YOLO 模块更善于应对这种变化性。在射箭项目中,两个模块的性能相似;在马拉松项目中,几何模块的性能优于 YOLO 模块。马拉松项目需要检测箭头标记,而 YOLO 模块难以区分不同类型的标记。图 7 展示了篮球项目的输出结果。

图 7:YOLO 比传统的分割方法更稳健,因此对背景噪声的抵抗力更强。

5.5 结果讨论

在静态测试中,几何模块在每秒帧数(FPS)方面始终优于 YOLO,由于计算成本较低,在所有场景下的平均速度高出 50%。然而,在复杂任务中,这种优势有所减弱。YOLO 在各项测试中保持了稳定的帧速率,这表明通过剪枝或硬件加速可能进一步优化性能。分析每帧处理时间可以明确每个模型的计算成本所在。

精度结果因项目而异。篮球和射箭项目的分数相当,而马拉松项目中 YOLO 的检测率更高,但由于类似箭头标记的频繁误分类,其有效准确性受到影响。这表明 YOLO 的置信度分数可能并不总是反映真实世界的可靠性。相比之下,几何模型的一致性使其不太容易出现此类假阳性,特别是对于形状重复的物体。在运动模糊等失真条件下进行进一步测试,可以更全面地评估系统的稳健性。

在涉及运动和实时决策的动态测试中,每秒帧数(FPS)的趋势保持一致:几何模块在速度方面领先,但由于检测复杂性,马拉松项目中的差距有所缩小。特定项目的挑战影响了性能表现。YOLO 在篮球项目中表现出色,比几何模块更善于处理光照变化和背景杂乱,而几何模块在遮挡情况下表现不佳。马拉松项目再次暴露了 YOLO 在区分相似标记方面的弱点,而几何模块则保持了更高的精度。射箭项目的条件相对均衡,两种方法的表现都很出色。

不同项目的精度差异显著。由于 YOLO 能够适应视觉噪声,在篮球项目中表现更优。在射箭项目中,两个模块都实现了较高的准确性,几何节点略占优势。在马拉松项目中,由于误分类,YOLO 的精度急剧下降。这些结果表明,最优模块的选择取决于任务背景:几何方法适合受控环境或对速度要求较高的应用,而 YOLO 在资源充足的动态、不可预测场景中表现更佳。

总体而言,结果凸显了一种权衡:几何模块在简单任务中速度快、效果好,但缺乏适应性;而 YOLO 能够处理复杂场景,但需要更高的计算成本。混合解决方案(YOLO 用于检测,几何方法用于优化)可能结合两者的优势。随着深度学习工具的不断发展,这两种方法仍然有效,具体选择取决于任务需求和硬件限制。

6 结论

6.1 研究发现总结

本研究成功展示了在人形机器人上部署基于 YOLO 的视觉模块的可行性,通过有针对性的优化克服了计算挑战。通过进行静态和动态实验,本研究全面评估了基于深度学习的目标检测与传统几何方法之间的权衡。结果并未表明其中一种模块更具优势,而是凸显了每种方法的优势和局限性,为机器人应用提供了有价值的见解。

静态实验证实,YOLO 能够实现较高的检测精度,在精度方面通常与几何方法相当。然而,几何模块的速度仍然明显更快,在某些场景下的处理帧速率几乎是 YOLO 的两倍。尽管这一结果符合预期,但这种效率差距凸显了进一步优化的必要性,特别是考虑到 OP3 的硬件限制。动态实验进一步强调了这种权衡。虽然 YOLO 表现出更强的稳健性,但其实时性能进一步下降。几何方法保持了速度优势,但在处理某些复杂物体类型时存在困难。这表明,尽管深度学习模型会带来显著的计算开销,但它们泛化到各种条件的能力可以显著提高实际可用性。

6.2 局限性与挑战

尽管该系统在受控条件下成功实现了实时检测,但仍需认识到一些局限性。首先,OP3 平台缺乏专用图形处理器(GPU),需要大量优化才能维持可接受的性能。即使经过量化和模型转换,在某些高需求场景中,推理速度仍然是一个显著的瓶颈。其次,由于必须保持较小的数据集规模,模型在需要区分相似物体的任务中表现出过度拟合的迹象。尽管系统在受控环境中表现良好,但光照和背景杂乱的变化在实际场景中仍然会对检测精度产生轻微影响。即使经过增强处理,环境条件的剧烈变化也表明,需要更具适应性的训练数据增强策略。解决这些挑战需要结合硬件改进、额外的软件优化以及训练过程的完善,以提高模型在各种操作条件下的泛化能力。

6.3 未来研究方向

本研究为未来的研究开辟了多个方向。一个关键领域是硬件加速。利用英特尔神经计算棒或树莓派人工智能加速器等边缘计算设备,可以减轻推理负担,降低计算压力。在网络环境中,基于云的推理或针对图形处理器(GPU)/ 现场可编程门阵列(FPGA)优化的实现可能显著提升性能,特别是在对延迟要求较高的场景中。

扩展数据集以包含各种环境条件,并利用迁移学习,可以进一步提高模型的泛化能力。更大或更多样化的数据集(可能借助合成数据生成)将有助于解决小规模样本导致的过拟合问题。

另一个有前景的方向是多模态传感。将 YOLOv9 与深度传感器或激光雷达(LiDAR)相结合,可以改善物体定位,特别是在遮挡或噪声较多的场景中。卡尔曼滤波等传感器融合技术可能减少不确定性,提高检测稳健性。

最后,自适应推理策略(如动态跳帧、分辨率缩放或基于系统负载的模型切换)可能优化性能。强化学习或自监督方法可以使模型在无需完全重新训练的情况下适应实际环境条件。

总之,本研究展示了在人形机器人上部署基于 YOLOv9 的视觉系统的可行性,通过有针对性的优化克服了硬件限制。该研究为深度学习与机器人技术的融合提供了灵活的基础,在自主导航、辅助技术和工业自动化等领域具有应用潜力。